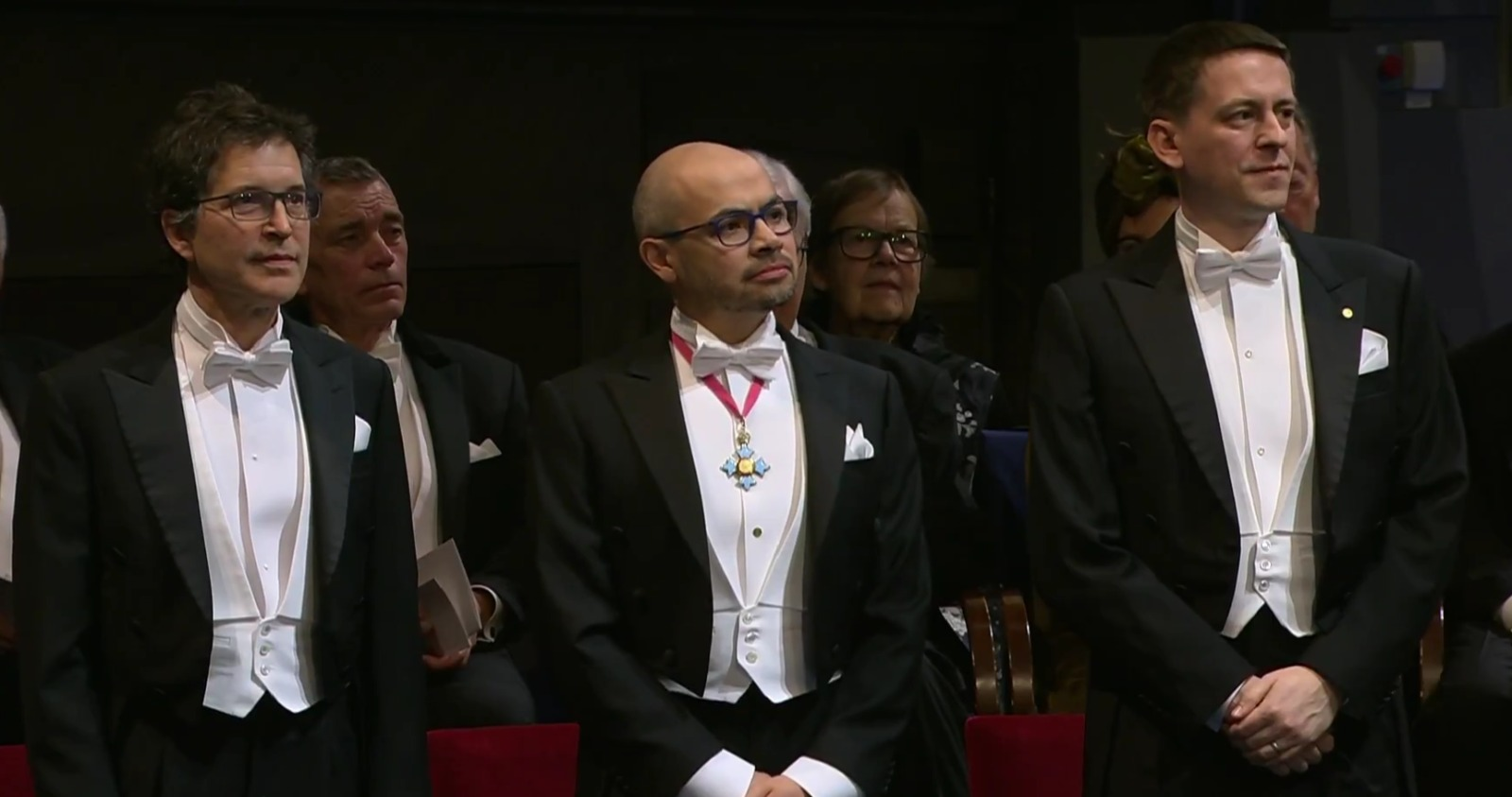

¿La IA va a poder curar enfermedades? La respuesta aún no es certera, pero no caben dudas de que hay gente trabajando para lograrlo. Para llegar a eso, primero tenemos que familiarizarnos con el mundo de las proteínas y cómo se revolucionó gracias al deep learning, al punto de que el año pasado se les otorgó el Nobel de Química a dos grupos de científicos que desarrollaron modelos de IA para la generación de proteínas. A David Baker por el "diseño computacional de proteínas"; y a Demis Hassabis y John Jumper por la "predicción de estructuras de proteínas".

Lo sorprendente también es el corto plazo en el que se lograron resultados relevantes que impactan exponencialmente en el campo de la salud. Como la mayoría de los modelos de IA que conocemos y utilizamos, todo esto fue posible gracias al desarrollo de la arquitectura Transformers (de ahí viene la T en ChatGPT) en 2017; su mecanismo de self-attention se pudo llevar a distintos dominios, como el texto o las imágenes. Y tres años más tarde, también al que nos interesa en esta nota: el de las proteínas.

Poder diseñar proteínas con funciones puntuales representaría un punto de quiebre en la industria de la salud (y en muchas otras) como la conocemos. Tener la capacidad de desarrollar anticuerpos sintéticos, vacunas en un menor período de tiempo o terapias personalizadas para cada paciente son apenas algunas de las implementaciones que pueden comenzar a transformarse en realidad.

Qué son las proteínas

Podemos decir que las proteínas son la maquinaria fundamental de la vida. De una manera menos poética, son cadenas muy largas de aminoácidos (AA) basadas en moléculas pequeñas que se unen entre sí. En la naturaleza hay sólo 20 y conforman un sinfín de proteínas; las más chicas tienen alrededor de 100AA, pero pueden llegar a haber otras formadas por miles y miles de AA.

Estas macromoléculas, al ser tan diversas, cumplen distintas funciones en todo nuestro cuerpo. Tal vez las más conocidas sean las que componen los tejidos musculares (de ahí que hablamos de "consumir proteínas" al comer carne), pero también existen las que favorecen o aceleran reacciones químicas, llamadas enzimas; o proteínas de transporte como la hemoglobina, encargada de cargar el oxígeno a través de la sangre.

Entre otros roles también están los anticuerpos que forman parte del sistema inmune, las proteínas de señalización y regulación y las de membrana y reconocimiento. En esta última categoría, durante la pandemia, se hizo muy conocida la proteína Spike, ubicada en la membrana del virus SARS-Cov-2 (war flashbacks). La Spike tiene mucha afinidad con el receptor ACE2, una enzima –sí, otra proteína– presente en la membrana de células de varios órganos, como el pulmón o el corazón. Cuando estas dos moléculas se unen –con otros procesos y más proteínas de por medio– el virus libera su material genético dentro de la célula, ocasionando la infección.

Cómo se estudian las proteínas

Conocer la estructura de una proteína es una pieza clave para poder comprender su función. Por ejemplo, para poder desarrollar una vacuna contra el Covid (existen distintas tecnologías, pero en este caso será la "proteína recombinante"), se produce la proteína Spike in vitro aislada del resto del SARS-Cov-2. Conociendo su estructura, se implementan modificaciones puntuales para mantenerla en la misma forma en la que se encuentra en la membrana del virus (estado prefusión, antes de unirse al receptor de la célula humana). Este paso es importante ya que al administrar la vacuna, el sistema inmune responde a la Spike con anticuerpos que bloquean la unión al receptor ACE2. Estos anticuerpos son los que se ligan a la Spike, aprendiendo así la respuesta, llegado el caso que el virus ingrese al organismo.

El tema es cómo pueden los investigadores analizar una proteína que tiene, en este caso, ~1200AA y una longitud de ~15nm (o sea, 0.000015 mm, ínfimo). Claramente, esto presentó un cuello de botella para el desarrollo biotecnológico basado en estas moléculas, y es por eso que la implementación de modelos de IA llegó para romper toda esta lógica.

El método estándar se llama cristalografía por rayos X y requiere de obtener primero una proteína que sea estable y en cantidades considerables. Luego se tiene que purificar la muestra y modificar químicamente el medio para poder obtener cristales (que las miles de copias de esa proteína se ordenen de manera repetitiva y uniforme). Este paso es crucial y complicado, ya que no todas las proteínas pueden formar estructuras cristalinas. Lo siguiente es exponerlas a rayos X para generar patrones de difracción que delatan cómo estas partículas interactuaron con el cristal. Ya la última etapa se vuelve muy compleja, utilizando transformadas de Fourier, mapas de densidad electrónica y programas de modelados estructurales. La salida de todo este proceso es finalmente un modelo atómico detallado de la proteína.

AlphaFold y RFdiffusion

Los dos modelos que hicieron eco en la comunidad científica fueron AlphaFold (desarrollado por Demis Hassabis y John Jumper) y RoseTTAFold/RFdiffusion (a cargo de David Baker).

En 2010, Hassabis junto a Shane Legg (que sigue siendo parte aunque ya no es tan citado) y Mustafa Suleyman (que se fue de la empresa en 2019) fundaron DeepMind, empresa centrada en inteligencia artificial general (AGI) y el Reinforcement Learning (RL) en el área de videojuegos. En 2014, Google se las compró por unos 500 millones de dólares. Y años más tarde, en 2018 y a cargo de Jumper, lanzaron AlphaFold1, el primer modelo que utiliza deep learning aplicado al desarrollo de proteínas. Éste aplicaba CNNs para predecir parámetros geométricos (distancias y ángulos) entre pares de aminoácidos y poder reconstruir la estructura de la proteína.

Si bien fue un hito, presentaba todavía limitaciones en cuanto a la exactitud con la que definía las posiciones de los átomos. El boom sucedió con AlphaFold2, que basó su arquitectura en los mecanismos de self-attention de Transformers (a este Transformer modificado lo llamaron Evoformer), aplicándolos a la secuencia de AA, captando relaciones estructurales de AA que tal vez en la secuencia se encuentran lejos pero en su estructura 3D, por los plegamientos, terminan siendo "vecinas".

Hasta ese momento, se conocía la estructura de alrededor de 120 mil proteínas, fruto de años de investigación y de técnicas estándar como la mencionada cristalografía. Luego de la aparición de AlphaFold2, se puede acceder a más de 200 millones de estructuras, cargadas en su propia base de datos AlphaFold DB, obviamente mantenida por DeepMind.

Por otro lado, los estudios iniciales de Baker se remontan a principios del 2000 con Rosetta, un programa que en base a modelos físicos y energéticos se utilizaba para predecir y diseñar proteínas in silico (o sea, virtualmente). Su enfoque se basaba en algoritmos computacionales clásicos, sin utilizar herramientas de IA. Durante la década del 2010, el equipo siguió trabajando y comenzó a incorporar machine learning clásico como random forests o regresiones, hasta que en 2021 lanzaron RoseTTAFold, que basa su arquitectura en AlphaFold2 pero con una implementación más accesible computacionalmente, y publicada open source.

RFDiffusion apareció en 2023 y lo innovador es que permite ingresar como input que la proteína final tenga ciertas funciones. A nivel de arquitectura, el modelo aplica el proceso de difusión generativa, que básicamente consiste en añadir ruido al dato de entrada y entrenar a la red para que pueda quitar ese ruido para, mediante RoseTTAFold y sus mecanismos de atención sobre las coordenadas 3D, obtener la estructura "limpia" de la proteína. Este modelo entonces no solo predice las estructuras sino que permite diseñar proteínas con funcionalidades específicas. Así como su antecesor, RFdiffusion también es open source.

En mayo del año pasado se publicó AlphaFold3, producto de DeepMind en colaboración con Isomorphic Labs, otra empresa también fundada por Hassabis y que también es parte de Google (en realidad de Alphabet Inc, la empresa matriz de Google). El core de este nuevo modelo es que puede predecir la interacción ligando-receptor, o sea cómo dos moléculas se unen entre sí. Por ejemplo, el ibuprofeno (fármaco o ligando) uniéndose a la ciclooxigenasa (una proteína que produce moléculas que generan dolor e inflamación).

Para esto se implementó un cambio en la arquitectura del modelo, y en línea con RFdifussion, se utilizó difusión generativa, algo más útil para poder predecir las distintas configuraciones posibles de sistemas más complejos multimoleculares. También incluye otras estructuras moleculares como el ARN o anticuerpo-antígeno, aunque para estos casos los resultados obtenidos no son tan sobresalientes. Lo prometedor de esta herramienta es que actualmente supera la técnica estándar, el docking computacional, para simular la interacción ligando-proteína, ya que puede capturar la flexibilidad de la proteína al verse afectada por la incorporación del ligando.

Lo que se viene

Isomorphic Labs es una de varias empresas que están dedicándose a utilizar IA para diseñar fármacos. A principios de este año, anunció que apuntan a tener una primera droga desarrollada en base a AlphaFold3 para finales de 2025 y que están poniendo el foco en las principales enfermedades: neurodegenerativas, cardiovasculares y oncológicas. En abril consiguieron, en su primera ronda de inversión, financiamiento por USD$600 millones y recientemente, en julio, en una entrevista para Fortune, su presidente, Colin Murdoch, anunció que están encaminados para comenzar con pruebas clínicas en humanos, de la mano de farmacéuticas importantes como Eli Lilly y Novartis.

Todo esto suena bastante prometedor y, si llegase a funcionar, los procesos de investigación y desarrollo de fármacos que normalmente duran entre 5 y 10 años pueden verse totalmente revolucionados, no sólo optimizando tiempos y costos sino que además se podría acceder al tratamiento de enfermedades complejas de abordar, pudiendo diseñar drogas en base a muchísimas simulaciones y configuraciones hasta obtener la que actúe de manera específica y más eficiente.

Sabemos que la IA llegó para quedarse, y el caso de las proteínas es una de las muchas aristas en la que está potenciando el área de la salud. Ya hay casos en los que su aplicación optimizó el diagnóstico, por ejemplo una detección temprana de cáncer de pulmón al implementar un modelo para analizar tomografías. En Argentina, incluso, existe Entelai, una empresa fundada en 2018 que está a la vanguardia del diagnóstico por imagen asistido por IA en la región.

No quiero dejar de mencionar que es imposible pensar en el avance de la IA sin que el desarrollo del hardware y la electrónica acompañen, por eso es que la computación cuántica (con su optimización en la capacidad de procesamiento) está resonando cada vez más, con grandes empresas como Google o Microsoft comenzando a lanzar procesadores cuánticos.